# Amazon S3 トリガー - New CSV file

Amazon S3 の選択したバケット/フォルダーに CSV ファイルが追加されるとトリガーします。

ポーリング間隔ごとに一度、新規または更新された CSV ファイルがないか、選択されたフォルダーをチェックします。出力には、ファイルのメタデータとファイルのコンテンツ (バッチ内の CSV 行として提供される) が含まれます。

Amazon S3 では、ファイルの名前が変更されると、新しいファイルと見なされることに注意してください。ファイルがアップロードされ、既存のファイルが同じ名前で上書きされると、新規ファイルではなく更新されたファイルと見なされます。

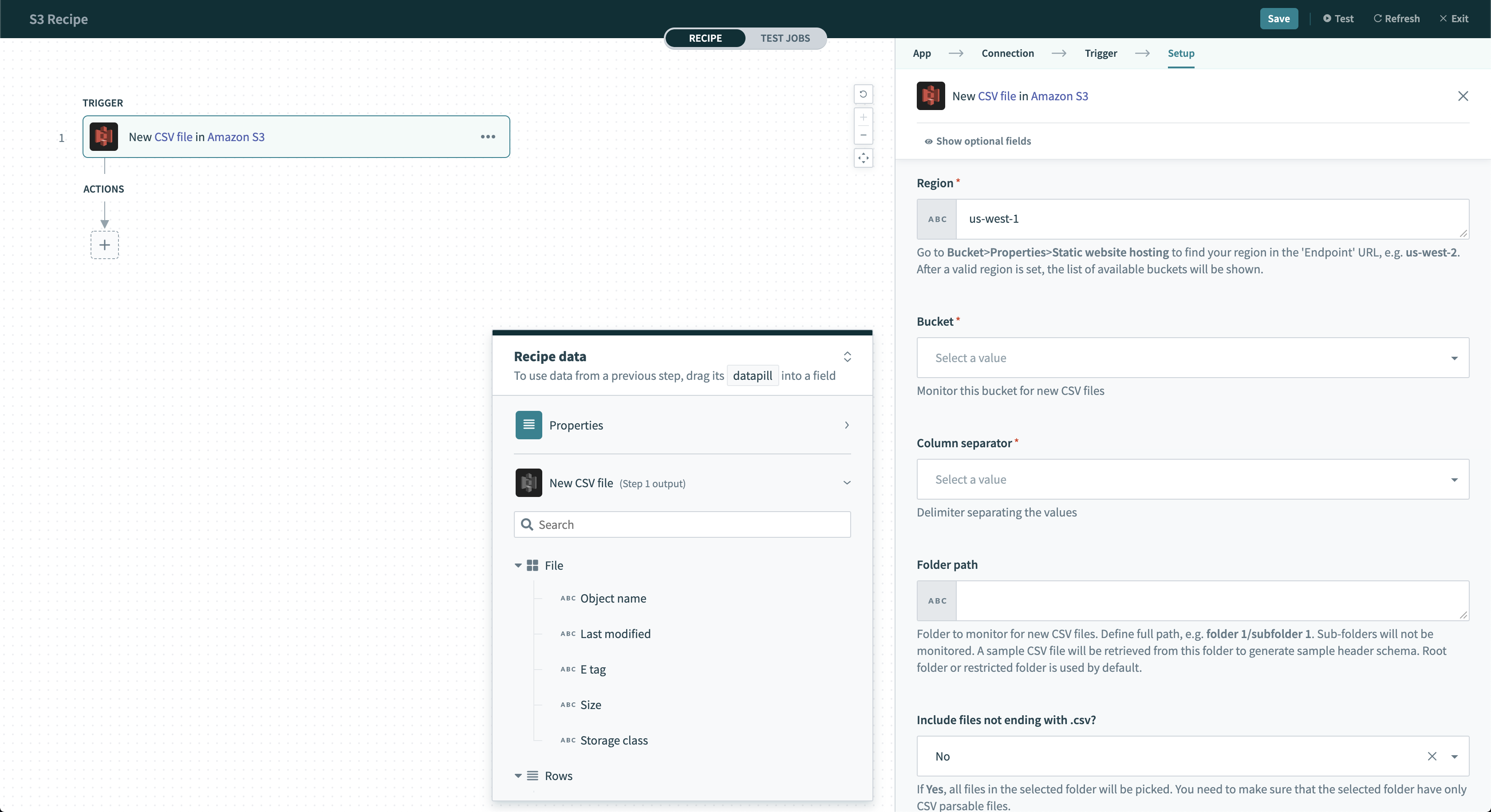

Amazon S3 - New CSV file トリガー

Amazon S3 - New CSV file トリガー

# 入力項目

| 項目名 | 説明 |

|---|---|

| When first started, this recipe should pick up events from | レシピを開始して最初に取得する CSV ファイルは、ここで指定した時刻以降に作成されたファイルとなります。レシピが実行またはテストされた後で、値を変更することはできません。この項目の詳細については、こちらを参照してください。 |

| Region | 新規/更新されたファイルを監視するバケットのリージョン (例 : us-west-2)。Amazon S3 で、 [バケット] > [プロパティ] > [静的ウェブサイトホスティング] に移動すると、エンドポイント URL 内でお客様のリージョンを確認できます。 |

| Bucket | 新しい CSV ファイルを監視するバケット。ピックリストからバケットを選択するか、バケット名を直接入力します。 |

| Column separator | CSV ファイル内で列を区切る区切り文字。 |

| Folder path | 新しい CSV ファイルを監視するフォルダー。完全なパスを定義します (例 : folder 1/subfolder 1)。サブフォルダーは監視されません。ルートフォルダーまたは制限されたフォルダーがデフォルトで使用されます。 |

| Include files not ending with .csv? | 他のシステムからエクスポートされた CSV ファイルに .csv 拡張子がないケースを処理します。このフォルダー内のすべてのファイルが CSV 解析可能であることを確認します。 |

| Column names | CSV ファイルの列名。列名は、行ごとに各列のヘッダーにより手動で定義できます。 |

| Batch size | Workato は、より効率的に処理するために CSV ファイルをサイズの小さいバッチに分割します。この項目は、各バッチで処理する CSV 行の数を定義します (最大1,000行/バッチ)。データスループットを向上させるには、バッチサイズを大きくします。API 制限の超過を避けるため、Workato で自動的にバッチサイズを小さくする場合があります。バッチ処理の詳細については、こちらを参照してください。 |

| Skip header row? | CSV ファイルにヘッダー行が含まれる場合は、 [Yes] を選択します。そうすると、その行はデータとして処理されません。 |

このトリガーはトリガー条件をサポートします。これにより、トリガーイベントをフィルタリングできます。

# 出力項目

| 項目名 | 説明 | |

|---|---|---|

| File | Object name | ファイルの完全名。 |

| Last modified | ファイルの最終変更時のタイムスタンプ。 | |

| E tag | ファイルオブジェクトのハッシュ。Amazon S3 により生成されます。 | |

| Size | ファイルサイズ (バイト単位)。 | |

| Storage class | このファイルオブジェクトのストレージクラス。通常は S3 Standard です。 | |

| Rows | Line | この CSV 行の数。 |

| Columns | この CSV 行のすべての列の値が含まれます。ネストされているデータピルを使用して、各列の値をマッピングできます。 | |

| List size | この CSV 行のリストの行数。 | |

←

接続方法

Last updated: 2023/8/31 1:07:14